GPSトラッカーMonimoto(モニモト)を選択した理由については以下の記事に書いています。GPSトラッカーMonimotoを選択したわけ

Monimotoはモニモト公式サイトより購入が可能です。 モニモト公式サイト

この記事では開封と初期設定、室内でテストを行ったレビューを書きます。

モニモトが入った箱は思ったより小さかったです。

箱の中身

箱に入っていたのは、Monimoto本体、マニュアル(グローバル版と日本語版)、専用キー、インシュロックです。

Monimoto専用キー

上の写真の赤丸の部分に切り込みがあり、そこにマイナスドライバーを差し込めばキーを開くことができます。

Monimoto本体

Monimoto本体を開けるには、マニュアルに書いてある通り思いっきり引っ張るしかありません。

本体を開けたら、中の絶縁シートを引き抜けば本体が起動し、本体のLEDランプが点滅します。

MonimotoのiPhone用アプリを起動して設定を開始すると、まずスマホの番号の入力画面が現れます。

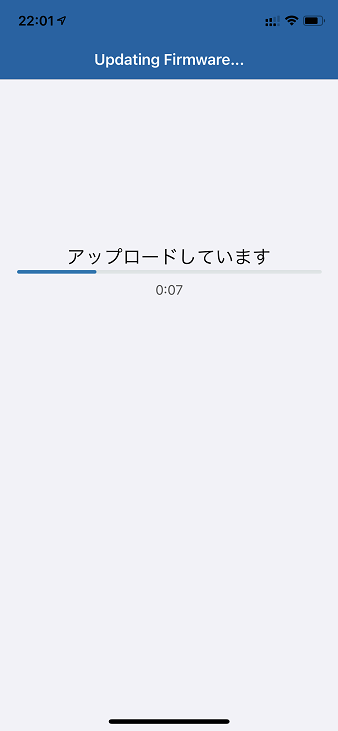

本体とのペアリング時にファームアップデートが掛かりました。

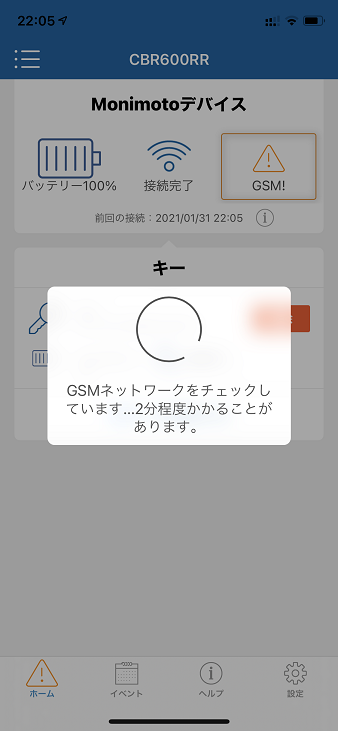

屋内の電波が悪いところで初期設定を行っていたので、SIMの通信が上手く行かずにGSMの初期設定が失敗したようです。※GSMとは3GやLTEなど携帯端末の通信規格で、いわゆる2Gのことですが、日本版は2Gではなく3Gでの通信となるようです。 (アプリ画面の表示は3GではなくGSMのままのようです)

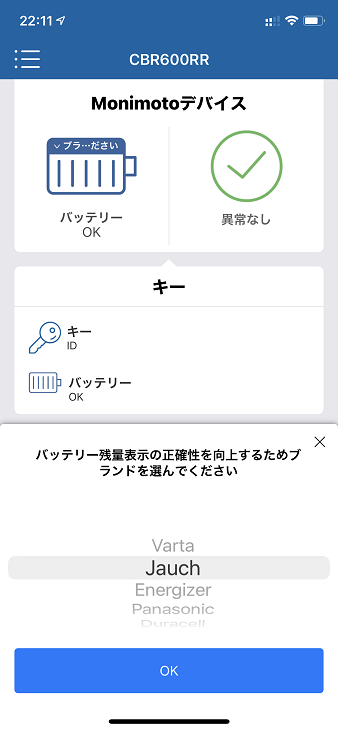

ちなみにリチウム電池のメーカーを選択すると残量表示がより正確になるとのことなので、本体を閉めてしまう前にリチウム電池のメーカーを確認しておきましょう。

下の写真のところでバッテリーの部分をクリックしてブランドを選択します。

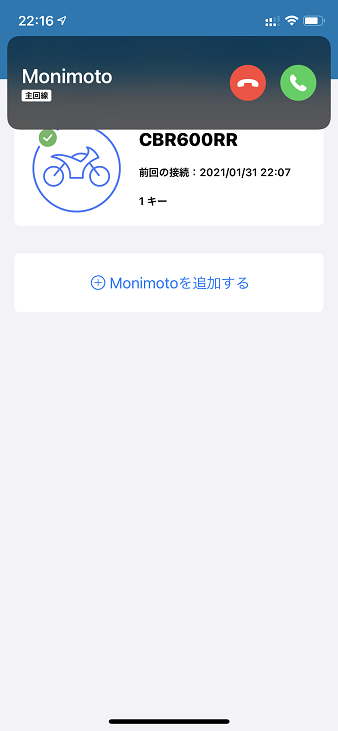

初期設定が終わると、本体のSIMカードから英語でSMSが届くので、その番号をスマホのアドレスに登録しておくと、Monimotoから電話が掛かって来た時に一目でわかるので、初期設定が済んだ時点で電話番号を登録しておきましょう。

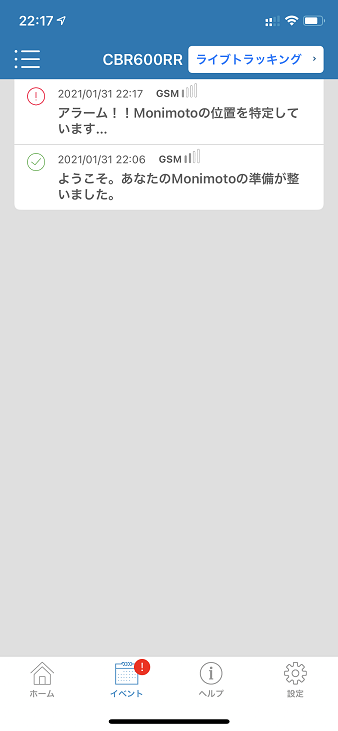

初期設定完了後にキーを離れた場所に置いてMonimoto本体を暫く揺すってみました。

電話時点ではGPS情報はまだ届かず、GSMの電波状況しかわかりませんでした。

室内で試していたのでGPS情報を取得することができず、その後の通知でもGPS情報は送られてきません。

なお、GPSが測位できない時は、電波を利用して「大まかな位置」を知らせてくれるのですが、その範囲は広く、更に私の場合は地図上に表示された「大まかな位置」の円の中にも入っておらず、かなりの誤差があることが分かりました。

Monimoto本体を室内から外に出してみたところ、無事にGPSを即位してGPS情報が送られてきました!

その後、Monimoto本体をキーに近付けると「Monimotoがキーを発見し、スタンバイモードになりました。」というメッセージが表示されてアラームモードからスタンバイモードに戻りました。

続いて、実際のバイクに搭載して走ってみました。

グローブボックスに放り込んだだけなので、マニュアルに書いてあるようにGPSの文字が車体の外に奇麗に向いているとは言い難い状態です。

この状態でキーを別の場所に置いて走り出すと、直ぐにAppleWatchに電話が掛かって来ました。

この製品の性格上、バイクのどこにMonimoto本体を隠したかを記事に書くことはできませんが、上手く隠せば十分に盗まれたバイクを追跡できそうです。

2021/02/02 追記

Monimotoはモニモト公式サイトより購入が可能です。 モニモト公式サイト